Короткий посібник із створення файлу Robots.txt

Як ознайомитися з величезним підручником? Просіювання індексу. Що ж: є один елемент, який є справжнім підсумком вашого веб-сайту…

Єдиний спосіб зв’язатися з павуком пошукової системи або гусеничний, через файл під назвою Robots.txt. Або краще. Коли ви надсилаєте свою пропозицію щодо веб-сайту в Google, він стикається з просто колосальною кількістю інформації.

Як ознайомитися з настільки великим підручником, що вам здається, що ви ніколи не знайдете всього, що вам потрібно? Ви консультуєтесь підказка. Добре: файл robots.txt є індексом вашого сайту.

Це простий для заповнення документ, який повідомляє сканеру пошукової системи, що шукати. Коротко: ви допоможете йому зрозуміти, з чого складається ваш сайт, щоб алгоритм міг дати вам рейтинг, який відповідає виконаній вами роботі.

Хтось може написати файл robots.txt?

Коротка відповідь: так. Чесна відповідь - ні. Хоча граматика файлу robots.txt надзвичайно проста, а його композиція складається з кількох рядків, краще покладатися на турботу досвідченого веб-майстра, який знає, куди прикласти свої руки. Зрештою, невеликої помилки достатньо, щоб скомпрометувати позиціонування вашого веб-сайту, і, отже, призупинити всі операції SEO, навіть не розпочавшись.

Перш ніж почати, знайте одне: будь-хто може переглянути файл robots.txt будь-якого сайту, написавши /robots.txt після домену. Ви навіть можете звернутися до Google!

Записати такий файл можна без завантаження спеціального програмного забезпечення. Насправді, достатньо скористатися блокнотом і зберегти, здогадайтеся, у форматі .txt.

Давайте разом напишемо robots.txt: заголовок

Почнемо з самого початку, як це завжди логічно. Початок файлу, точніше заголовок, повністю присвячений імені павука, якому передує маленьке формулювання, яке завжди однакове. Припустімо, ви хочете, щоб Google помітив вас. Отже, перший рядок буде таким:

Агент користувача: Googlebot

Цей дуже короткий рядок повідомляє Google, що все, що йде далі, обов’язково зацікавить його. Якщо ви хочете, щоб усі веб-сканери, які читають цей тип файлу, могли переглядати документ, замініть Googlebot простим *, a зірочка.

Тепер, коли ви вказали, який павук, тобто ХТО, вам потрібно буде вказати також ЩО йому доведеться прочитати.

Кожен рядок коду, за визначенням, відповідає дії машини. Само собою зрозуміло, що кожна команда у файлі robots.txt відповідає тому, чого машина не повинна робити. І це той ключ, який дозволяє написати дійсно ефективний. Мова йде про команду DISALLOW.

Що таке команда DISALLOW?

Il заборонити команду дозволяє міркувати шляхом виключення. Іншими словами, коли кажуть, що спочатку потрібно сказати, чого не слід робити – ну, ви міркуєте виключенням. На додаток до заборони є також дозвіл, який є винятком для блокування.

Якщо ви хочете написати хороший файл robots, вам доведеться подумати навпаки, тож вам доведеться сказати Google, що він не повинен читати. Якщо ви пишете:

Disallow:

Павук прочитає весь ваш сайт, без жодних гальм.

Якщо після «Disallow:» вставити косу риску (тому Disallow: /), то сайт не буде занесений в пошукові системи, крапка.

Заборонити: /каталоги/

Замініть слово каталог папкою, яку потрібно заборонити перегляду павука. Ви можете зробити те саме з певним файлом.

Заборонити: /myfile.html

Увага до розділові знаки та літери, великі чи малі літери. Цей тип файлу дуже цінує такі «дрібниці», але вони мають велике значення.

Чому ви заважаєте Google читати значну частину вашого сайту? Коли ви пишете файл такого типу, важливо розуміти, які файли не повинні з'являтися в пошуковій системі, але не зловживати ними. Однак знайте, що кожен, хто знає точну адресу цього конкретного файлу, зможе отримати до нього доступ у будь-якому випадку.

Що таке команда ДОЗВОЛИТИ?

У файл ви можете додати виняток за допомогою команди ДОБАВИТИ. Граматика ідентична, але вона створить деякі винятки для DISALLOW, які дозволять відкрити цікаві поля для дослідження для павука.

Невеликий приклад файлу:

Агент користувача: Googlebot

Заборонити: /images/

Дозволити: /images/holidays.jpg

По суті, ми сказали Googlebot не розглядати папку із зображеннями, за винятком окремої фотографії в ній, а саме фотографії зі свят.

І це, хлопці, все. Ми написали наш перший файл robots.txt. Звичайно, те, що ми збираємося зробити для фактичного сайту, може дещо відрізнятися, але не дуже. Якщо сумніваєтеся, завжди звертайтеся за порадою до спеціалізованого веб-майстра. Радимо вам, перш за все, спробувати написати його самому і відправити йому на перевірку, щоб освоїти основи і краще зрозуміти, як працює ваш сайт.

Яка кореляція між robots.txt і картами сайту?

Карта сайту – це файл, створений спеціальними плагінами, який містить усі посилання на сайті. Коли павук заходить на сайт, він спочатку читає роботи, а потім сканує сайт. Якщо під час сканування робот знайде адресу карти сайту, весь процес буде набагато легшим.

До наведеного вище коду додайте наступне:

Карта сайту: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

На закінчення

Усі файли robots однакові. Це означає, що файл Robots, написаний для Google, також добре працюватиме для Bing і дотримується тієї самої граматики.

Добре організований файл robots.txt дозволяє заощадити час сканера. Не падайте духом: це перший крок до успіху!

Вас також може зацікавити:

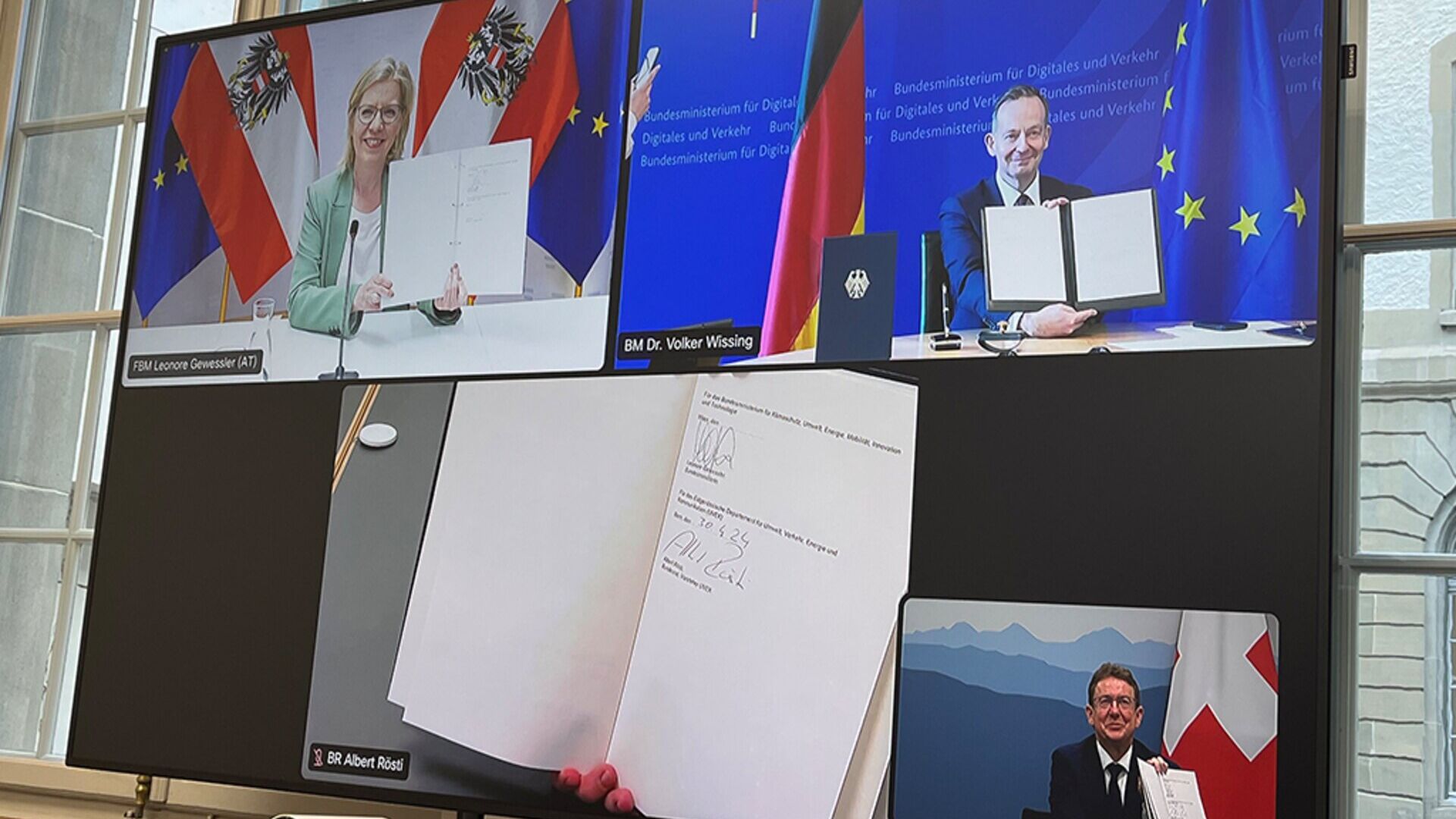

Австрія, Німеччина та Швейцарія за «інноваційніші» вантажні залізниці

Міністри DACH Леонор Гевеслер, Фолькер Віссінг і Альберт Ресті: запровадження цифрового автоматичного сполучення є ключовим елементом

Переконання чи маніпулювання? Генезис та історичний вплив PR

Ось як зв’язки з громадськістю, від витонченого діалогу стародавньої Греції до сучасної цифрової ери, продовжують пропонувати постійні інновації

Молодь і криптовалюти: як дізнатися більше про Bitcoin…

Знайомство дітей із цифровими валютами та блокчейном може бути захоплюючим завданням, враховуючи їхню прихильність до технологій та інновацій

«Пацієнт у центрі»: велика надія і зустріч у Сенаті

Тему важливості інновацій у медичних пристроях для європейської охорони здоров’я досліджуватимуть 15 травня в Римі експерти та політики

Альберто НіколініРедактор Districtbiomedicale.it, BioMed News і Radio Pico